> 汽车交通

hadoop如何保证数据安全(hadoopchecksum)

导语:Hadoop新增校验功能,防数据损坏,保护端到端数据完整性

新的Apache Hadoop端到端数据完整性验证,有助于验证不同存储系统间传输数据的完整性,也能检测出因内存错误造成的数据损坏。

为确保用户数据在传输过程未被更改,Google、twitter以及Apache Hadoop开源社区合作,为Apache Hadoop加入跨异构文件系统的端到端数据验证功能,能用于如HDFS以及Google Cloud Storage间数据传输的校验。

Google提到,在不同存储系统间移动或是复制数据的时候,最好执行验证以确保数据安全,虽然现在有不少机制在保护点到点传输数据的完整性,但是执行端到端的数据完整性验证,则可以为典型传输机制增加额外的保护。当然这也可以帮忙检测因为网络、服务器以及路径上的路由器因内存错误造成的数据损坏。

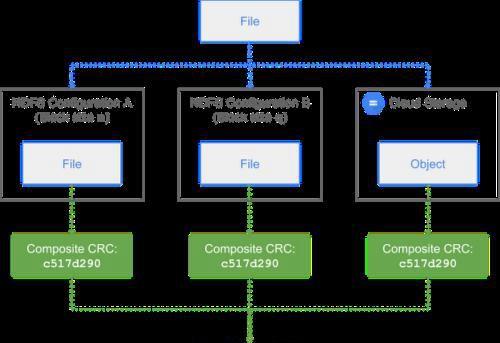

Google、twitter以及Apache Hadoop开源社区三方合作,创建了新的校验码类型,能将复合模块CRC以及复合文件CRC,定义为跨存储区块CRC的数学组合CRC。这取代了使用组件CRC的MD5,以计算代表整个模块或是文档的单一CRC,而且与区块CRC较低等级的精细度无关。

Apache Hadoop从3.1.1版本开始提供新的CRC校验功能,同时也会在2.7、2.8以及2.9版本向后兼容,不过使用者还必须要再等等。

免责声明:本站部份内容由优秀作者和原创用户编辑投稿,本站仅提供存储服务,不拥有所有权,不承担法律责任。若涉嫌侵权/违法的,请与我联系,一经查实立刻删除内容。本文内容由快快网络小信创作整理编辑!