AI大算力爆发!四大新兴赛道卡位风口,龙头全梳理

AI大算力爆发!四大新兴赛道卡位风口,龙头全梳理

GPT模型在持续迭代过程中,能力持续增强,算力需求同样也呈几何倍增长。

现阶段的 ChatGPT 是在拥有 3000 亿个单词的语料基础上预训练拥有 1750 亿参数的模型。

据 OpenAI 测算,2012 年以来全球头部 AI 模型训练算力需求 3-4 个月翻一番,每年头部训练 模型所需算力增长幅度高达 10 倍,远超摩尔定律的增长速度。

据此前 IDC 预测,预计到 2025 年,中国数据圈将增长至 48.6ZB,占全球数据圈的 27.8%,成为全球最大的数据圈。

AI 大算力的高需求将提升服务器性能,AI 服务器需搭载多个 CPU 和 GPU 处理器,同时服务器 CPU性能不断升级,要求内存技术同步升级。

DDR5、HBM、CXL、NVLink 等新兴技术有望加速渗透,并充分受益于 AI 带来的算力需求增长。

服务器一般可分为通用服务器、云计算服务器、边缘服务器、AI服务器等类型。

AI服务器专为人工智能训练和推理应用而设计,大模型带来算力的巨量需求,有望进一步推动AI服务器市场的增长。

其中,训练任务对服务器算力要求较高,需要训练型服务器提供高密度算力支持,典型产品有中科曙光X785-G30和华为昇腾Atlas 800(型号9000、型号9010)。

一个典型的人工智能服务器的 DRAM 容量是普通服务器的 8 倍,NAND 容量是普通服务器的 3 倍。

根据IDC数据,2022年全球AI服务器市场规模202亿美元,同比增长29.8%,占服务器市场规模的比例为16.4%,同比提升1.2pct。

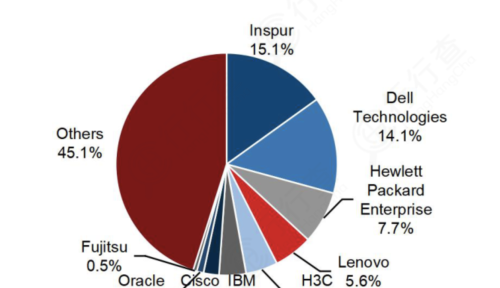

2022年上半年全球AI服务器市场中,浪潮、戴尔、惠普、联想、新华三分别以15.1%、14.1%、7.7%、5.6%、4.7%的市场份额位居前五位。

人工智能服务器:算力爆发打开空间,龙头全梳理

根据 TrendForce,2023 年 ChatGPT 相关应用有望再度刺激 AI 相关领域,预计 2023 年出货量增长率可达 8%,2022-2026 年复合成长率将达 10.8%。

海量数据对存储的需求持续推动内存接口芯片量价齐升和市场高速扩容。

持续受益于服务器出货量增长和单台服务器内存模组用量不断上升。

内存接口是服务器 CPU 与内存桥梁,当前正迎来DDR5 升级。

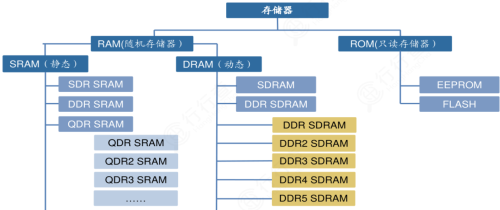

从存储的分类看,存储主要可分为RAM(随机存储器)和ROM(只读存储器)。

RAM可分为SRAM(静态随机存储器)和DRAM(动态随机存储器)。

SDRAM(同步动态随机存取存储器)是在DRAM的基础上发展而来,为DRAM的一种。

DDR SDRAM(双倍速率同步动态随机存储器)又在SDRAM的基础上发展而来,为具有双倍传输率的SDRAM,其数据传输速度为系统时钟频率的两倍,由于速度增加,其传输性能优于传统的SDRAM。

DDR SDRAM经历了DDR2、DDR3、DDR4等几代技术更迭,其差异性主要体现存储器的电源电压值越来越低,而数据传输速率却是呈几何倍数增长,同时存储容量也随之大幅增加。

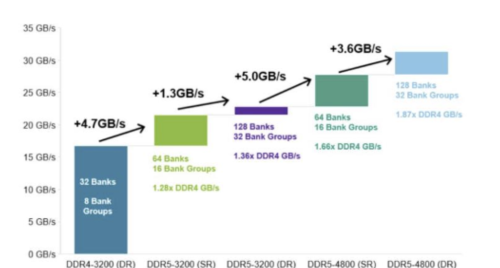

DDR5 内存性能远超 DDR4 的规格上限,配套内存接口芯片性能及技术难度随之提升。

根据市场调研机构推测,DDR5 已占据整个 DRAM 市场份额的 10%,2024年则将进一步扩大至 43%。服务器市场对高性能有着绝对的需求,可能最先推广DDR5。

随着新一代DDR产品的升级,内存接口芯片有望迎来量价齐升,DRAM市场有望开启新一轮增长

数据来源:EEtop

内存接口芯片行业壁垒高,竞争格局相对较好。国内澜起科技正在拓展津逮@服务器平台&PCIe Retimer 和 AI 芯片产品线;聚辰股份SPD 受益于算力需求增加及 DDR5 升级。SPD 用于服务器等领域,受益于 算力需求增加及 DDR5 升级。聚辰和澜起科技合作开发配套新一代 DDR5 内存条的 SPD 产品,该产品系列内置 SPD EEPROM,系 DDR5 内存模组不 可或缺组件。

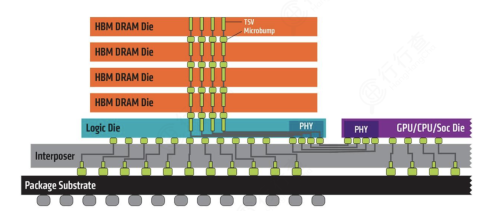

行行查 | 行业研究数据库 数据显示,高带宽存储器(HBM)是一款新型的CPU/GPU 内存芯片,通过将多个DDR芯片堆叠在一起,实现大容量,高位宽的DDR组合阵列。

HBM 可支持更高速率的带宽,并实现高于256GBps 的突破性带宽,单颗粒的带宽远超过DDR4 和GDDR6。

HBM将为大算力芯片提供能力支撑,同时生成类模型也会加速 HBM内存进一步增大 容量和增大带宽。

如今搭载于新兴 AI 应用的内存芯片亟待升级,这种设计能够大大提升信息交换的速率。

资料来源:AMD

从竞争格局来看,全球范围内,HBM2内存核心厂商主要包括SK海力士、三星、Altera、英特尔和超微半导体等。

全球第一梯队厂商主要有SK海力士、三星、Altera和英特尔;第二梯队厂商有超微半导体和美光。

海力士HBM技术起步早,占据较大市场,2018年发布HBM2,2021年发布全球首款HBM3,目前在研HBM4。

三星从HBM2开始布局,2016年量产HBM2,2021年2月,三星电子推出了HBM-PIM(存算一体),将内存半导体和AI处理器合二为一,2022年HBM3已量产。

国内布局厂商中,通富微电在Chiplet、WLP、SiP、Fanout、2.5D、3D堆叠等方面均有布局和储备;深科技是国内最大的独立DRAM内存芯片封测企业,全球第二大硬盘磁头制造商,全资子公司沛顿科技封装技术包括 wBGA/FBGA 等,具备先进封装 FlipChip/TSV 技术(DDR4 封装)能力;长电科技具有高集成度的晶圆级WLP、2.5D/3D、系统级(SiP)封装技术和高性能的Flip Chip和引线互联封装技术;兆易创新是国内存储龙头,是国内技术最为先进的存储厂商,NORFlash、NAND Flash及MCU为主要产品的业务板块。

TrendForce 预估 2023-2025 年 HBM 市场年复合成长率有望成长 至 40-45%以上。

CXL:存储芯片界CPO随着存储成本不断增加,传统的PCI-e技术逐渐乏力。在此背景下,基于PCI-e协议的CXL技术应运而生。

CXL 全称为 Compute Express Link,是由英特尔于 2019 年 3 月在 Interconnect Day 2019 上推出的一种开放性互联协议,能够让 CPU 与 GPU、FPGA 或其 他加速器之间实现高速高效的互联,从而满足高性能异构计算的要求。

快速成长的人工智能(AI)与机器学习(ML)新兴任务,持续激增的云端运算以及网络和边缘的“云端化”将成为推动CXL发展的重要因素之一。

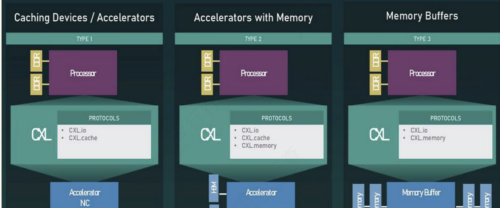

CXL技术用途:

资料来源:CXL Consortium

CXL联盟董事会成员包括Intel、Google、IBM、Facebook等科技巨擘,发起者Intel拥有80%服务器CPU市场份额。

CXL联盟成员:

根据TrendForce,CXL导入将随着未来CPU内建CXL功能而普及化。同时CXL建立数据高速互联性的优点,有助于扩展AI算力,未来AI服务器将能见到更多采用CXL的设计。

澜起科技推出首款支持CXL的MXC芯片并研发支持CXL的PCIe Retimer芯片。

美光科技在 22 年 5 月与投资者交流 时曾预测 CXL 相关产品的市场规模,到 2025 年预计将达到 20 亿美金,到 2030 年 可能超过 200 亿美金。

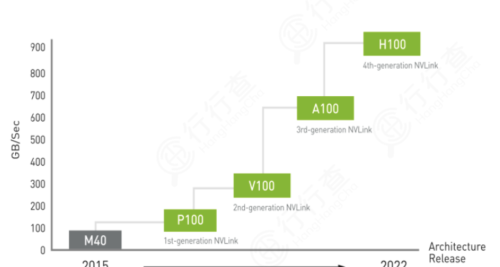

NVLink:芯片互连技术NVLink 是为了解决服务器内部 GPU 之间点到点通讯的一种协议。

英伟达在2023年美国消费电子展(CES)上,发布了数据中心专属CPU——“Grace CPU超级芯片”。该芯片由两颗CPU芯片组成,其间通过NVLink-C2C技术进行互连。

NVLink-C2C技术是一种新型的高速、低延迟、芯片到芯片的互连技术,可最大化提升系统吞吐量。

与Chiplet技术有异曲同工之妙,可支持定制裸片与GPU、CPU、DPU、NIC、SoC实现互连。

第四代 NVIDIA® NVLink®技术可为多 GPU 系统 配置提供高于以往 1.5 倍的带宽,以及增强的可扩展性,进而实现超快速的深度学习训练。

随着模型参数数量增大,训练所需要算力不断增长,英伟达有望进一步巩固公司龙头 地位。

国内厂商浪潮推出的NF5688M6是新一代NVLink AI 服务器,在超大规模数据中心研发的同时拥有高性能,高兼容,强扩展性能。在6U空间内支持2颗Intel最新的Ice Lake CPU和8颗NVIDIA最新的NVSwitch全互联 A800 GPU,结合AI算力资源调度平台AIStation,能够释放强大AI计算性能。

随着人工智能、机器学习、高性能计算、数据中心等应用市场的兴起,内存产品设计的复杂性正在快速上升,并对带宽提出了更高的要求。海量的算力数据和不断上升的宽带需求持续驱动人工智能新技术发展。

关注乐晴智库,洞悉产业格局!